Promovendus verbetert beeldclassificatie met slechts één extra regel code

24 november 2022

Neem een groot aantal medische scans waarvan artsen willen weten welke een tumor vertonen en welke niet. De trainingsgegevens bevatten waarschijnlijk veel meer scans zonder tumor dan met tumor. Wanneer een automatisch beeldherkenningssysteem nu wordt getraind op zo’n ongebalanceerde dataverzameling, en er geen extra maatregelen worden genomen, is de kans groot dat het systeem tumoren mist, wat natuurlijk ongewenst is.

In het algemeen geldt dat hoe minder een bepaald voorbeeld voorkomt in een dataverzameling, hoe meer het wordt genegeerd door de huidige machinaal lerende systemen. En omdat veel dataverzamelingen in de praktijk ongebalanceerd zijn, negeren veel toepassingen onterecht dataklassen die slechts enkele voorbeelden bevatten.

Paper geaccepteerd

Promovenda Tejaswi Kasarla van het Video & Image Sense Lab VIS van het UvA Instituut voor Informatica (IvI) ontwikkelde in haar eerste jaar een elegante en onconventionele oplossing voor dit probleem. Samen met vijf collega's beschreef ze de oplossing in een artikel dat werd geaccepteerd en geselecteerd als mondelinge presentatie voor de prestigieuze Conference on Neural Information Processing Systems NeurIPS, die van 28 november tot 4 december 2022 wordt gehouden in New Orleans (VS

'Onze oplossing geeft evenveel belang aan alle klassen in de dataverzameling, onafhankelijk van of een klasse veel of weinig voorbeelden bevatTejaswi Kasarla

'Onze oplossing geeft evenveel belang aan alle klassen in de dataverzameling', zegt Kasarla, 'onafhankelijk van of een klasse veel of weinig voorbeelden bevat. De oplossing voegt voorkennis toe aan de gegevens. Als je het aantal klassen weet, dan vertelt ons algoritme je precies hoe je de klassen gelijk moet verdelen.'

Kasarla en haar co-auteurs testten de oplossing in drie gevallen, waaronder onevenwichtig opgebouwde dataverzamelingen. Kasarla: 'Voor alle drie de testgevallen presteerde onze oplossing aanzienlijk beter dan de best beschikbare alternatieve methode. Toen we onze methode bijvoorbeeld testten op de veelgebruikte CIFAR-dataverzameling, behaalden we een winst van twaalf procentpunten in het geval dat de grootste klasse honderd keer meer voorbeelden bevatte dan de kleinste klasse. Hoe onevenwichtiger een dataverzameling is, hoe meer voordeel onze oplossing oplevert.'

Eén extra regel code

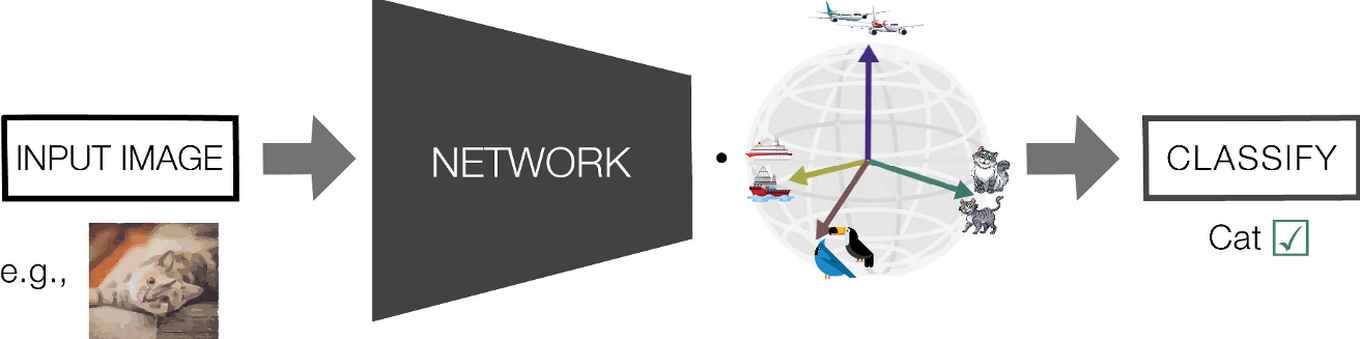

Verrassend genoeg is de oplossing gebaseerd op het toevoegen van slechts één extra matrixvermenigvuldiging aan de laatste laag van het neurale netwerk, zegt Kasarla's promotiebegeleider en UvA assistant professor Pascal Mettes: 'De oplossing is algemeen toepasbaar en kan worden geïmplementeerd in slechts één extra regel code. Die extra regel leidt niet eens tot een meetbare toename van de tijd die het kost om het computerprogramma te runnen.' Kasarla kreeg al veel positieve reacties van internationale collega's die haar eenvoudige oplossing willen gebruiken.

'De norm voor promovendi in onze groep is om na vier jaar tijd vier artikelen gepubliceerd te hebben, maar in het eerste jaar van je promotie een artikel publiceren dat geaccepteerd wordt op een topconferentie is wel heel bijzonderPascal Mettes

De echte, alledaagse wereld bevat niet alleen een enorme variatie in beeldklassen en groottes van de klassen, er komen ook voortdurend nieuwe beeldklassen bij, bijvoorbeeld omdat er nieuwe producten op de markt komen. 'In onze methode kunnen we gemakkelijk nieuwe klassen toevoegen', zegt Kasarla, 'dus we denken dat het heel nuttig kan zijn voor machinaal lerende systemen die voortdurend over nieuwe klassen moeten leren.' Dit wordt een van de richtingen voor haar toekomstig onderzoek tijdens de rest van haar promotietraject.

'De norm voor promovendi in onze groep is om na vier jaar tijd vier artikelen gepubliceerd te hebben', zegt Mettes, 'maar in het eerste jaar van je promotie een artikel publiceren dat geaccepteerd wordt op een topconferentie is wel heel bijzonder.'

Details van de publicatie

Tejaswi Kasarla, Gertjan J. Burghouts, Max van Spengler, Elise van der Pol, Rita Cucchiara, Pascal Mettes

Title 'Maximum Class Separation as Inductive Bias in One Matrix.'