Wat het menselijke brein wel en AI niet kan

16 juni 2025

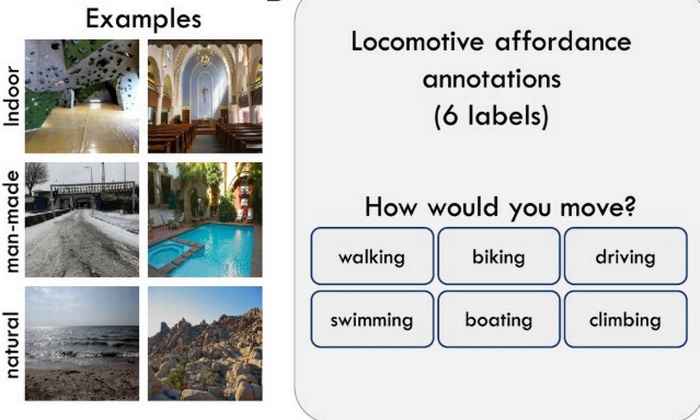

Wanneer we een plaatje van een onbekende omgeving zien —een bergpad, een drukke straat of een rivier—weten we direct wat we in die omgeving kunnen: wandelen, fietsen, zwemmen of juist niet verder gaan. Dat klinkt logisch, maar hoe weet je brein eigenlijk wat mogelijk is?

PhD student Clemens Bartnik toont samen met een aantal mede-auteurs aan hoe we dankzij unieke hersenpatronen inschattingen van mogelijke acties maken. Ook vergeleek het team, geleid door hersenwetenschapper Iris Groen, dit menselijke vermogen met een groot aantal AI-modellen, waaronder ChatGPT. ‘AI-modellen bleken hier minder goed in en kunnen nog veel leren van het efficiënte menselijke brein,’ concludeert Groen.

Beelden kijken in de MRI-scanner

Met behulp van een MRI-scanner onderzocht het team wat er in de hersenen gebeurt wanneer mensen naar uiteenlopende foto’s van binnen- en buitenomgevingen kijken. De deelnemers gaven met een knopje aan of de afbeelding uitnodigde tot lopen, fietsen, rijden, zwemmen, varen of klimmen. Tegelijkertijd werd hun hersenactiviteit gemeten.

‘We wilden zo weten: als je naar een scène kijkt, zie je dan vooral wat er ís—zoals objecten of kleuren—of zie je ook automatisch wat je ermee kunt dóén,’ vertelt Groen. ‘Dat laatste noemen psychologen “affordances”—mogelijkheden tot actie. Denk aan een trap die je kunt beklimmen, of een open veld waar je doorheen kunt rennen.’

Unieke processen in de hersenen

Het team ontdekte dat bepaalde gebieden in de visuele hersenschors actief worden op een manier die niet verklaard kan worden door zichtbare objecten in het beeld. ‘Wat we zagen was uniek,’ zegt Groen. ‘Deze hersengebieden representeren niet alleen wat er te zien is, maar ook wat je ermee kunt doen.’ Het brein deed dit zelfs wanneer deelnemers geen expliciete actieopdracht kregen.

Zelfs als je niet bewust nadenkt over wat je in een omgeving kunt doen, registreren je hersenen het tochHersenwetenschapper Iris Groen

‘Deze actiemogelijkheden worden dus automatisch verwerkt,’ stelt Groen. ‘Zelfs als je niet bewust nadenkt over wat je in een omgeving kunt doen, registreren je hersenen het toch.’Het onderzoek bewijst daarmee voor het eerst dat affordances niet alleen een psychologisch concept zijn, maar ook een meetbare eigenschap van onze hersenen.

Wat AI nog niet begrijpt

Het team vergeleek ook hoe goed AI—zoals beeldherkenningsmodellen of GPT-4—kunnen inschatten wat je in een bepaalde omgeving kan doen. Deze bleken veel slechter in het voorspellen van mogelijke acties. ‘Als ze specifiek getraind worden op actieherkenning, konden ze de menselijke beoordeling wel enigszins benaderen, maar de menselijke hersenpatronen kwamen niet overeen met de interne berekeningen van de modellen,’ legt Groen uit.

‘Zelfs de beste AI-modellen geven niet precies dezelfde antwoorden als mensen, terwijl het zo’n simpele taak voor ons is,’ zegt Groen. ‘Dit laat zien dat onze manier van kijken diep verweven is met hoe we ons door de wereld bewegen. We verbinden onze waarneming aan onze ervaring in een fysieke wereld. AI-modellen kunnen dat niet omdat ze slechts in een computer bestaan.’

AI kan leren van het menselijk brein

Het onderzoek raakt daarmee aan grotere vragen over de ontwikkeling van betrouwbare en efficiënte AI. ‘Nu steeds meer sectoren—van gezondheidszorg tot robotica—AI inzetten, wordt het belangrijk dat machines niet alleen herkennen wat iets is, maar ook begrijpen wat ermee kan’, legt Groen uit. ‘Denk aan een robot die de weg moet vinden in rampgebieden, of een zelfrijdende auto die een fietspad herkent.’

Daarnaast wijst Groen op het duurzame aspect van AI. ‘De huidige AI-trainingsmethodes kosten enorm veel energie en zijn vaak alleen bereikbaar voor grote techbedrijven. Meer kennis over hoe ons brein werkt, en hoe het menselijk brein bepaalde informatie razendsnel en efficiënt verwerkt, kan AI slimmer, zuiniger en mensvriendelijker helpen maken.’

Details artikel

Bartnik et al, 'Representation of locomotive action affordances in human behavior, brains, and deep neural networks', in: PNAS, Vol. 122, No. 24. Ga naar het artikel